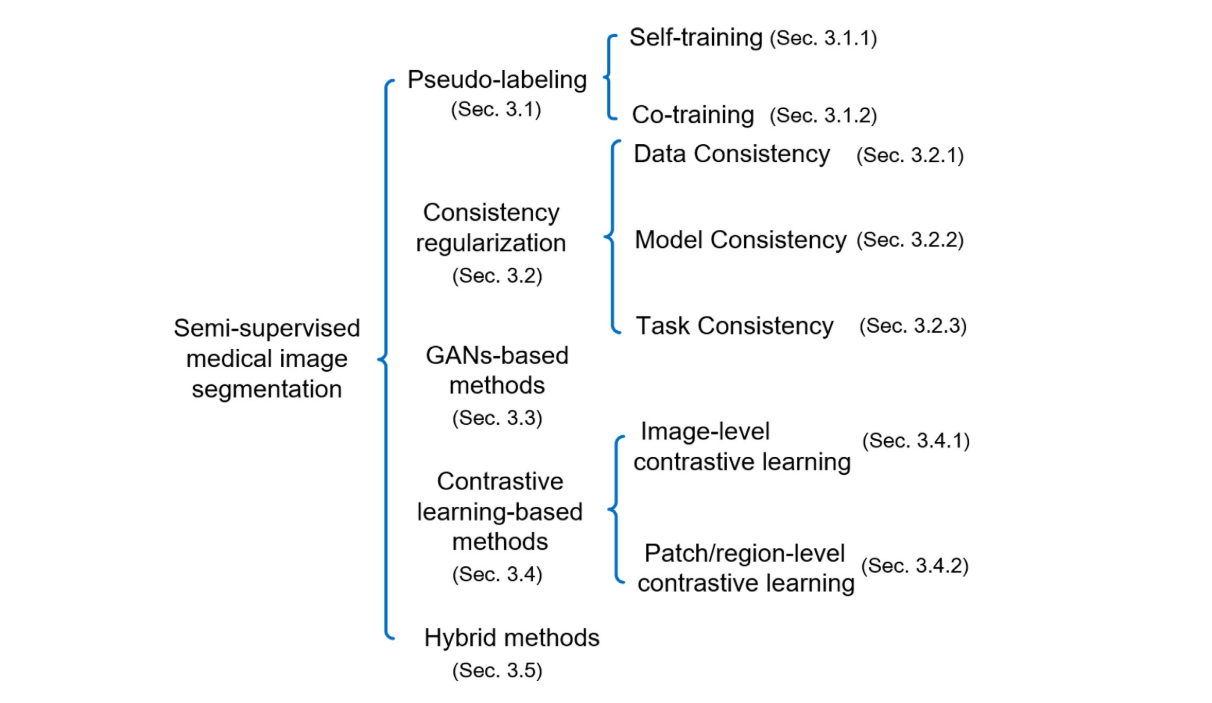

Deep semi-supervised learning for medical image segmentation:A review

Problem overviews Problem definition 半监督学习的核心目标即是通过利用大量未标记的数据来提高监督学习的性能。在本文的半监督学习设置中,假设数据集DDD由两部分组成: 标签样本集DL=(Xi,Yi)i=1LD_L=(X_i,Y_i)_{i=1}^LDL=(Xi,Yi)i=1L和无标签样本集DU=(Xi)i=L+1L+ND_U=(X_i)_{i=L+1}^{